مخاطر التشخيص الذاتي باستخدام روبوتات الدردشة الذكية: وجهة نظر طبية

Table of Content

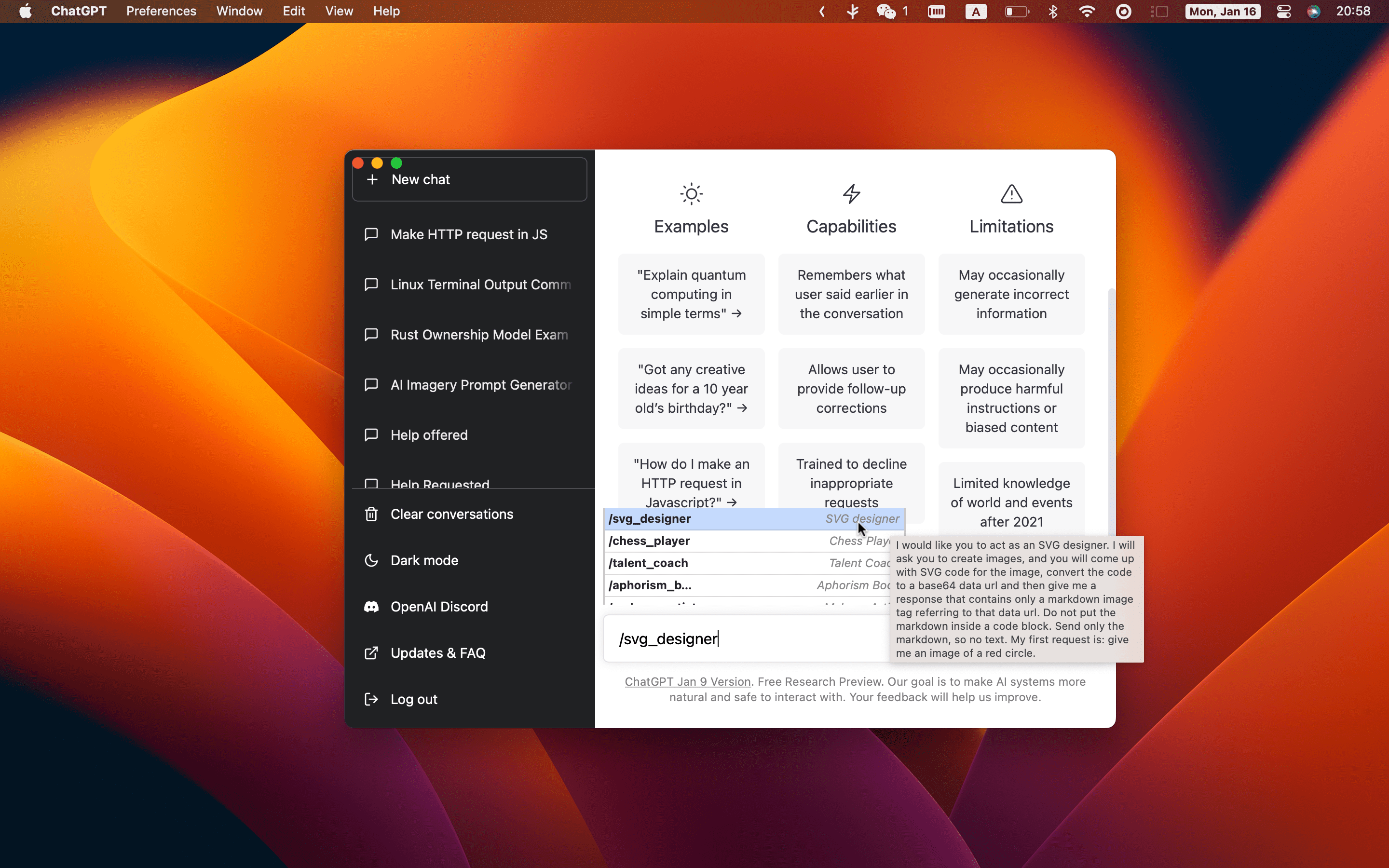

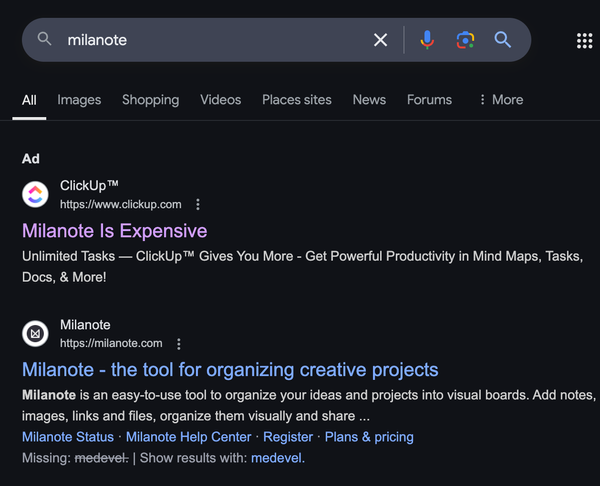

بصفتي طبيبًا ومطورًا للبرمجيات، لاحظت مؤخرًا اتجاهًا مثيرًا للقلق: يزور عدد متزايد من المرضى عيادتي مسلحين بمعلومات تم جمعها من روبوتات الدردشة الذكية وخدمات مثل ChatGPT وMicrosoft Copilot وGoogle Gemini.

والأمر الأكثر إثارة للقلق هو أن العديد من المرضى يحاولون تشخيص أنفسهم باستخدام هذه الأدوات.

في حين حقق الذكاء الاصطناعي بلا شك تقدمًا ملحوظًا ويحمل إمكانات هائلة في مجال الرعاية الصحية، فإن الاعتماد على روبوتات الدردشة الذكية للتشخيص الذاتي يمكن أن يؤدي إلى عواقب وخيمة.

وإليك الأسباب

١- أدوات الذكاء الاصطناعي ليست بديلاً عن الخبرة الطبية

يمكن لأدوات وبرامج الدردشة الذكية، المدربة على مجموعات بيانات ضخمة، توليد معلومات طبية دقيقة على ما يبدو.

ومع ذلك، فإنها تفتقر إلى الفوارق الدقيقة والحكم السريري والفهم السياقي الذي يأتي من سنوات من التدريب الطبي.

لا يتعلق الطب بالتعرف على الأعراض فحسب؛ بل يتعلق بفهم التفاعل المعقد بين التاريخ الطبي للمريض والصحة الحالية والبيئة والحالة العقلية.

في حين أن برنامج الدردشة قد يوفر قائمة بالتشخيصات المحتملة بناءً على الأعراض، فإنه لا يستطيع إجراء الفحوصات الجسدية أو ملاحظة الإشارات غير اللفظية أو تفسير الحالات الأساسية.

يمكن أن يؤدي هذا القيد في بعض الأحيان إلى التشخيص الخاطئ أو العلاجات غير المناسبة أو القلق غير المبرر.

٢- مخاطر المعلومات المضللة والتعميم المفرط

غالبًا ما تعتمد برامج الدردشة الذكية مثل ChatGPT على المعلومات العامة. في حين أن هذا يمكن أن يكون مفيدًا للمعرفة الأساسية، إلا أنه يمكن أن يؤدي إلى التعميم المفرط أو التفسيرات الخاطئة.

على سبيل المثال، قد يتلقى شخص يبحث عن معلومات حول الصداع مجموعة من الأسباب المحتملة، من الصداع التوتري الشائع إلى أورام المخ النادرة.

في الممارسة العملية، رأيت مرضى كانوا مقتنعين بأنهم يعانون من حالات شديدة أو نادرة بعد استشارة محركات البحث، فقط ليكتشفوا أن أعراضهم كانت ناجمة عن أسباب أقل خطورة بكثير.

هذا التشخيص الذاتي المضلِّل يخلق ضغوطًا وقلقًا غير ضروريين، مما قد يؤدي في الواقع إلى تفاقم النتائج الصحية.

٤- التخصيص غير الكافي

تفتقر أدوات الذكاء الاصطناعي إلى القدرة على الوصول إلى التاريخ الطبي الكامل للمريض ما لم يتم دمجها في نظام طبي. وحتى مع التكامل، فقد تكافح من أجل مراعاة العوامل المعقدة التي تنطوي عليها عملية التشخيص والعلاج.

على سبيل المثال، قد تقترح خدمات الذكاء الاصطناعي علاجات تعتمد فقط على الأعراض، متجاهلة العوامل الحرجة مثل الحساسية، أو الحالات الأساسية، أو التفاعلات الدوائية المحتملة. وقد يؤدي هذا الافتقار إلى الرعاية الشخصية إلى مخاطر صحية خطيرة.

٥- العلاج الذاتي غير المناسب والرعاية المهنية المتأخرة

إن أحد أخطر المخاطر المترتبة على التشخيص الذاتي من خلال روبوتات الدردشة الذكية هو إمكانية الحصول على علاجات غير مناسبة. فقد يتناول المرضى أدوية بدون وصفة طبية بناءً على اقتراح من الذكاء الاصطناعي، دون أن يدركوا أن هذه العلاجات قد تتفاعل بشكل خطير مع أدويتهم الحالية أو تؤدي إلى تفاقم حالة موجودة.

والأمر الأكثر إثارة للقلق هو ميل المرضى إلى تأخير طلب المشورة الطبية المهنية.

وقد يؤجلون زيارة الطبيب حتى تتفاقم المشكلة بشكل كبير، بعد اقتناعهم بأنهم قاموا بتشخيص أنفسهم بدقة.

وقد يؤدي هذا التأخير إلى تطور حالات خطيرة كان من الممكن إدارتها بشكل فعال بالتدخل المبكر.

٦- صعوبات في توصيف الأعراض بدقة

حتى بالنسبة للأفراد المتمرسين في مجال التكنولوجيا والمهرة في كتابة المطالبات - مثل مهندسي المطالبات - فإن وصف الأعراض الطبية بدقة لروبوت الدردشة الذكي يمثل تحديًا.

في الطب، يمكن أن تكون الفروق الدقيقة في وصف الأعراض هي الفارق بين تشخيص حالة بسيطة أو شيء أكثر خطورة.

اللغة التي نستخدمها لوصف أعراضنا غالبًا ما تكون ذاتية؛ ما قد يعتبره المريض إزعاجًا خفيفًا قد يكون بمثابة إشارة تحذير لمقدم الرعاية الصحية.

على سبيل المثال، قد يبدو وصف الألم بأنه "حاد" أو "باهت"، أو شرح كيفية تغيره مع الحركة، أمرًا مباشرًا.

ومع ذلك، يتطلب الأمر سياقًا طبيًا لتفسيره بشكل صحيح. تعتمد روبوتات الدردشة الذكية بشكل كبير على الصياغة الدقيقة للمرضى، وإذا تم وصف الأعراض بشكل سيئ أو سوء فهمها من قبل الذكاء الاصطناعي، فقد يكون التشخيص الناتج غير دقيق أو مضلل.

بصفتي طبيبًا، واجهت حالات حيث واجه المرضى - على الرغم من مهارتهم في صياغة مطالبات مفصلة ومعقدة - صعوبة في التعبير عن أعراضهم بطريقة تؤدي إلى تشخيص دقيق تم إنشاؤه بواسطة الذكاء الاصطناعي.

وهذا يسلط الضوء على قيد أساسي: في حين قد يتفوق مهندسو المطالبات في توليد أوامر فعالة لأنظمة الذكاء الاصطناعي، فإن جسم الإنسان معقد للغاية ودقيق للغاية بحيث لا تتمكن هذه الأوصاف من التقاط الصورة الكاملة.

مخاطر التشخيص الذاتي باستخدام روبوتات الدردشة الذكية

- التشخيص غير الصحيح: قد يسيء الذكاء الاصطناعي تفسير الأعراض، مما يؤدي إلى استنتاجات صحية خاطئة.

- زيارات الطبيب المتأخرة: الاعتماد على نصيحة الذكاء الاصطناعي قد يؤجل الرعاية الطبية اللازمة.

- خيارات العلاج غير الآمنة: قد تتعارض اقتراحات الذكاء الاصطناعي مع الأدوية أو الحالات الحالية.

- القلق غير الضروري: قد يسرد الذكاء الاصطناعي حالات خطيرة، مما يسبب ضغوطًا غير مبررة.

- الاعتماد المفرط على التكنولوجيا: قد يثق المستخدمون في الذكاء الاصطناعي أكثر من المتخصصين الطبيين المدربين.

- عدم وجود مسؤولية: لا توجد مساءلة إذا قدم الذكاء الاصطناعي نصيحة خاطئة.

صعوبة وصف الأعراض: قد يواجه المستخدمون صعوبة في نقل مشكلاتهم الصحية بدقة إلى الذكاء الاصطناعي. - عدم وجود فحص بدني: لا يمكن للذكاء الاصطناعي إجراء فحوصات عملية ضرورية للتشخيص الدقيق.

- مخاوف الخصوصية: قد يؤدي مشاركة البيانات الصحية مع منصات الذكاء الاصطناعي إلى تعريض المعلومات الشخصية للخطر.

ماذا ينبغي للمرضى أن يفعلوا بدلاً من ذلك؟

بصفتي طبيبًا، أشجع المرضى على النظر إلى أدوات الذكاء الاصطناعي كمكملات للنصائح الطبية المهنية، وليس كبديل لها. وفيما يلي بعض النصائح لاستخدام هذه الأدوات بشكل مسؤول:

- جمع المعلومات، وليس التشخيص: يمكن أن تكون روبوتات الدردشة التي تعمل بالذكاء الاصطناعي مفيدة لجمع معلومات الصحة العامة. ومع ذلك، استشر دائمًا أخصائي الرعاية الصحية لتفسير هذه المعلومات في سياق صحتك.

- طرح الأسئلة وتجنب الافتراضات: لا بأس من استخدام أدوات الذكاء الاصطناعي لمعرفة المزيد عن الأعراض أو الحالات، ولكن لا تفترض أنها تقدم الصورة الكاملة. استشر دائمًا مقدم الرعاية الصحية للحصول على تفسير مناسب.

- إعطاء الأولوية للرعاية المهنية: إذا كانت لديك أعراض مقلقة، فلا تتردد. اطلب العناية الطبية على الفور. من الأفضل بكثير الحصول على تشخيص دقيق وراحة بال بدلاً من الاعتماد على نصيحة الذكاء الاصطناعي غير المؤكدة.

- حالتك تخصك أنت: لا يمكن لأي أداة ذكاء اصطناعي أن تستوعب تمامًا تاريخك الطبي الفريد وأسلوب حياتك وعوامل صحية أخرى. ثق في طبيبك لتقديم رعاية شخصية بناءً على ملفك الصحي الشامل.

الخلاصة: الذكاء الاصطناعي في الرعاية الصحية - أداة قوية، وليس حلاً

تقدم برامج الدردشة التي تعتمد على الذكاء الاصطناعي مثل ChatGPT وMicrosoft Copilot وGoogle Gemini تطورات واعدة في مجال الرعاية الصحية، لكنها لا تحل محل الأطباء البشريين.

يتطلب الطب السياق والتعاطف والفهم العميق لجسم الإنسان - وهي الصفات التي لا يستطيع الذكاء الاصطناعي، في شكله الحالي، تكرارها ببساطة.

بصفتي طبيبًا، أناشدك استخدام الذكاء الاصطناعي بمسؤولية. اعتبره مصدرًا إضافيًا للمعلومات، وليس أداة تشخيصية.

عندما يتعلق الأمر بصحتك، لا شيء يفوق الخبرة والتعاطف والمساءلة التي يتمتع بها أخصائي الرعاية الصحية.